De nombreuses préoccupations juridiques, éthiques et politiques sont suscitées par l’utilisation de ces armes qui interviennent de manière de plus en plus autonome et que l’on appelle les « robots tueurs ». De quelles armes parle-t-on précisément ? Dans quelle mesure peuvent-elles être considérées comme un « progrès » ? Quels enjeux éthiques soulèvent-elles ?

À la fin du mois de novembre 2023, les autorités israéliennes indiquaient avoir frappé plus de 15 000 cibles dans les trente-cinq premiers jours du conflit à Gaza. C’est trois fois plus qu’au cours des cinquante et un jours qu’avait duré l’opération « Bordure protectrice », en 2014. Quelques jours plus tard, le magazine israélien de gauche +972 dévoilait une enquête révélant les raisons de ce rythme effréné : un programme informatique dopé à l’intelligence artificielle surnommé Habsora (« l’Évangile », en français) et fonctionnant comme une « usine à cibles », vingt-quatre heures sur vingt-quatre.

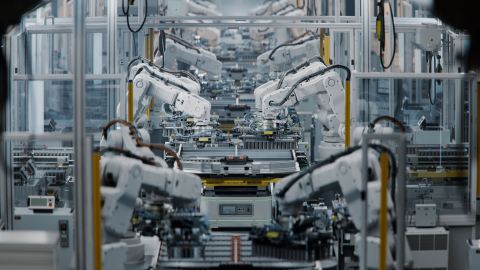

Le recours à ce type de technologie dans les conflits armés tend à s’accroître, du fait des progrès fulgurants dans le domaine de l’intelligence artificielle (IA) et de la robotique permis par la quatrième révolution industrielle. Parmi ces nouveaux instruments de la guerre, les « systèmes d’armes létales autonomes » (Sala), ou « robots tueurs » dans leur appellation plus médiatique, suscitent d’importantes interrogations éthiques.

Ces armes capables d’identifier et d’ouvrir le feu sur une cible sans intervention humaine font en effet l’objet d’un vaste débat, ouvert par des organisations non gouvernementales (ONG) qui se sont coalisées en 2013 au sein d’une Campaign to Stop Killer Robots. Ce travail de sensibilisation a donné lieu à des discussions internationales dans le cadre de la Convention sur certaines armes classiques (CCAC) puis à l’Assemblée générale des Nations unies (AGNU) et même au Conseil de sécurité des Nations unies (CSNU).

Alors que des prototypes de ces armes sont développés par un nombre croissant d’États – tels que la Chine, la Corée du Sud, les États-Unis, Israël ou la Russie – et qu’elles devraient être de plus en plus répandues dans la décennie à venir, une réflexion éthique sur leur emploi s’impose. Dans Phèdre, Platon alertait sur le risque de subversion technocratique, par lequel ce qui est moralement souhaitable se verrait déterminé par ce qui est techniquement possible. Il convient alors de s’interroger sur le progrès moral induit par l’émergence de moyens de combat déshumanisés dans la guerre, à l’aune des enjeux militaires mais aussi de considérations humanitaires.

> Lire l'article en intégralité dans la revue Etudes.

Contenu disponible en :

Régions et thématiques

Utilisation

Comment citer cette publicationPartager

Centres et programmes liés

Découvrez nos autres centres et programmes de rechercheEn savoir plus

Découvrir toutes nos analysesVers une nouvelle maîtrise des armements ? Défis et opportunités de l’expiration de New START

Signé en 2010 entre Barack Obama et Dmitri Medvedev pendant une période de détente entre les deux grandes puissances, New START (New Strategic Arms Reduction Treaty) devrait – sauf revirement de dernière minute – expirer le 5 février 2026. Héritier des grands traités de réduction des armements stratégiques de la guerre froide entre l’URSS et les États-Unis, ce traité a permis de réduire les arsenaux nucléaires russes et américains de plus de 30 % par rapport au début du XXIe siècle, en instaurant des limites quantitatives sur le nombre de têtes nucléaires stratégiques déployées – c’est-à-dire immédiatement utilisables – et des mécanismes de transparence et de vérification mutuelles.

L’autonomisation dans le milieu sous-marin : une révolution sans limite ?

L’un des facteurs stratégiques déterminants de la guerre russo-ukrainienne en cours est le recours massif à des capacités dronisées, aériennes mais aussi maritimes et terrestres, qui révolutionnent la physionomie du champ de bataille. Pour autant, force est de constater qu’une partie significative de ces drones est encore télépilotée, téléopérée ou encore télésupervisée, attestant du fait que l’autonomisation des capacités militaires est encore en gestation.

Char de combat : obsolescence ou renaissance ?

Depuis février 2022, les forces russes et ukrainiennes ont perdu plus de 5 000 chars de combat, un volume très supérieur à l’ensemble du parc européen actuel. Fer de lance de la doctrine soviétique dont sont issus les deux belligérants, le char a été déployé en grand nombre et s’est avéré être une cible de choix pour des drones devenus de plus en plus nombreux et efficaces au fil des mois. Le grand nombre de vidéos de frappes de drone contre des chars a d’ailleurs poussé un certain nombre d’observateurs à conclure, une fois de plus, à l’obsolescence de ceux-ci sur un champ de bataille moderne. Cette approche doit être nuancée par une étude plus fine des pertes, les drones n’étant que rarement à l’origine de la perte elle-même causée par la conjugaison de plusieurs facteurs comme les mines, l’artillerie ou d’autres armes antichar.

Quelle autonomie capacitaire pour l’Europe ? Une analyse multi-domaine

La dégradation de la situation sécuritaire en Europe depuis l’invasion à grande échelle de l’Ukraine incite les pays européens à accroître significativement leurs capacités militaires pour rester dissuasifs face à la menace majeure que représente désormais la Fédération de Russie. Par ailleurs, la politique américaine de burden shifting incite les Européens à envisager une moindre contribution des États-Unis à la défense du continent en général. Ce constat appelle à identifier plus finement le degré d’autonomie capacitaire des nations européennes et de leurs armées.